qmxocynjca

Участники форума-

Постов

172 -

Зарегистрирован

-

Победитель дней

1

Тип контента

Профили

Форумы

Галерея

Загрузки

Блоги

События

Весь контент qmxocynjca

-

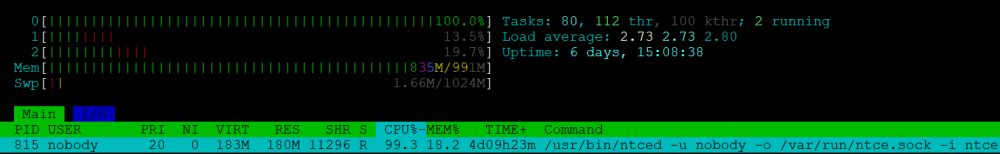

На 5.0.4 аналогично через пару дней CPU начинает уходить в потолок. Очень похоже на классический n^2, когда на мелких объемах баг не заметен, но с ростом тормозить начинает очень сильно.

-

Включил тут на свою голову этот сервис, дабы роутер по-умному делил канал между клиентами, но тоже постоянно вижу похожую дичь при смешных нагрузках (5-10мбит), т.е. дело явно не в большом трафике. Один раз дошло до того, что веб даже не мог открыть, пришлось ребутать через telnet. Девайс NC-1812, канал всего 100мбит. По началу оно работает, но через какое-то время начинается такое безобразие.

-

@slomblobov понимаю что приоритет вообще нулевой, но может вот этот фикс накатите хотя бы? https://github.com/avahi/avahi/issues/40#issuecomment-531047292 Он влияет только на файл с кастомными хостами, который Кинетик пока никак не создаёт. Я его попробую через entware подсовывать и погляжу на сколько это работоспособно.

-

Хорошее дело! Терминал в веб через ttyd поднимается в один вызов, это я тоже осилил Более интересный вариант - запустить ndmc через авторизацию по куке или как-нибудь еще без ввода явного пароля. Может придумаете/доработаете в прошивке? Тогда ttyd вполне и в нативный веб можно дотащить, было бы шикарно.

- 4 ответа

-

- 1

-

-

Что-то грустно. Даже с mws encapsulation не работает?

-

Такое ощущение что DNS ответы парсятся на сколько это возможно, и если что-то парсеру не нравится то в логику наполнения списков они не попадают. Вручную nslookup www.youtube.com тоже как-то не ахти наполняет списки сейчас. Даже не знаю что ещё сказать... Ждём, надеемся, верим.

-

На 5.0.3 всё ещё какая-то явная проблема. После перезагрузки роутера включаю запись на chrome://net-export, иду на youtube.com, вижу фигу. В логе net-export вижу UDP DNS запрос к роутеру, по dependency явно виден ответ от роутера и следующим за ним коннект к 173.194.222.198:443. При этом 173.194.222.198 не появился в show object-group fqdn. DNS на роутере настроен в режиме интернет-фильтра где в системном профиле заданы несколько DoT, включая 8.8.8.8. Устройство точно использует системный DNS профиль и дефолтную политику. Ответ включал именно этот адрес: HOST_RESOLVER_DNS_TASK_EXTRACTION_RESULTS --> results = [ { "domain_name": "wide-youtube.l.google.com", "endpoints": [ { "address": "173.194.222.198", "port": 0 } ], "hosts": [], "query_type": "A", "source": "dns", "strings": [], "timed_expiration": "13410556011478764", "type": "data" },

-

@Le ecureuil похоже есть проблема с обработкой DNS TCP запросов. Хром в какой-то момент вместо UDP может использовать TCP на 53 порт. Я вижу что зарезолвленные IP не наполняют списки в этом случае. Воспроизводится так: 1. Добавляем список с единственным доменом example.com 2. Делаем nslookup set vc example.com www.example.com Видим что example.com наполнился IP адресами в show object-group fqdn, а www.example.com уже нет. Делаем nslookup www.example.com (в UDP режиме), и видим что IP адреса появились у www.example.com. Конец.

-

На 5.0.2 улучшений нет, к сожалению. Всё так же некоторые IP идут мимо.

-

Присоединяюсь к вопросу. Точно так же думал что создам отдельный сегмент со всеми VPN-юзерами, а правилами уже разрешу куда кому можно, но по факту это либо не работает, либо правила нужны какие-то не очевидные. Я ещё не пробовал вариант с указанием диапазона адресов в sstp/oc сервере в той же сети что и сегмент. Это вроде как должно работать, и может даже правила тогда тоже заработают. Если у кого есть время и желание, попробуйте, пожалуйста.

-

Кто-то пользуется usque сейчас? Работает? У меня пинги через туннель идут, но "curl --interface opkgtunX ip.wtf" висит и ничего не происходит. MTU покрутил - толку не дало. upd: создал отдельный opkgtun, там завелось. До этого пытался через тот же что был в использовании на awg до этого, видать что-то не стыковалось.

-

@Le ecureuil почему-то openconnect URL не отдаёт всю цепочку сертификатов, как это происходит в обычном URL. * TLSv1.3 (IN), TLS handshake, Server hello (2): * TLSv1.3 (OUT), TLS change cipher, Change cipher spec (1): * TLSv1.3 (OUT), TLS handshake, Client hello (1): * TLSv1.3 (IN), TLS handshake, Server hello (2): * TLSv1.3 (IN), TLS handshake, Encrypted Extensions (8): * TLSv1.3 (IN), TLS handshake, Certificate (11): * TLSv1.3 (OUT), TLS alert, unknown CA (560): * SSL certificate problem: unable to get local issuer certificate Посмотреть на цепочку можно так, там видно что отсутствует один серт: # вот это не работает без явного указания -k/--insecure curl -w %{certs} -4 -k https://abcd.server.netcraze.link/?secret > cacerts_bad.pem # тут всё норм, curl не ругается curl -w %{certs} https://server.netcraze.link/ > cacerts.pem Сертификаты на системе из ca-certificates_20250419_all.deb. Обойти это можно, но кажется что это баг.

-

Пытаюсь повесить ping-check на Proxy интерфейс, использую для проверки mode connect, хост доступен, ping-check успешно переводит соединение в рабочий режим, но в логах начинает сыпаться такое. Пока отказался от ping-check. Ноя 26 19:08:34 Proxy0 0x7f909217c0 socks5 session connect Ноя 26 19:08:34 Proxy0 0x7f909217c0 socks5 client connect Ноя 26 19:08:34 Proxy0 0x7f909217c0 socks5 client connect

-

Смотрите где накосячили, возможно ENABLED=no прописали и забыли. В этом случае скрипт вот так ничего не делает прям как у вас. Может что-то ещё сломали, постарайтесь разобраться просто сравнив два файла S21 и S22.

-

Никак. После выкл/вкл интернета оно вроде само поднимается. Но если надо, то логично в iflayerchanged.d отлавливать ipv4==running на интерфейсе провайдера и дёргать рестарт необходимым сервисам в /opt/etc/init.d.

-

вот так делать не надо. путь должен быть в PATH ниже, а здесь должно быть только имя экзешника, иначе логика по остановке/перезапуску работает некорректно. Починили в итоге? В чём прикол был?

-

Проверьте по startup-config что OpkgTun1 настроен по аналогии с OpkgTun0, но при этом IP адрес должен быть другим. У меня работает сетап с двумя интерфейсами корректно. interface OpkgTun0 description awg-go-warp security-level public ip address 172.16.0.2 255.255.255.255 ip mtu 1280 ip global 7281 ip tcp adjust-mss pmtu ping-check profile warp up ! interface OpkgTun1 description awg-go-warp1 security-level public ip address 172.16.0.3 255.255.255.255 ip mtu 1280 ip global 3640 ip tcp adjust-mss pmtu ping-check profile warp up ! Бинарь amneziawg-go симлинками заведен на amneziawg-go0 и amneziawg-go1, чтобы при остановке одного не останавливался другой. Скрипт для запуска первого бинаря. Второй думаю осилите сами: #!/bin/sh ENABLED=yes PROCS=amneziawg-go0 AWG_INTERFACE=opkgtun0 ARGS="$AWG_INTERFACE" PREARGS="" DESC=$PROCS PATH=/opt/sbin:/opt/bin:/opt/usr/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin post_cmd() { COUNTER=0 LIMIT=10 while [ "$COUNTER" -le "$LIMIT" ]; do if awg setconf $AWG_INTERFACE /opt/etc/awg_$AWG_INTERFACE.conf 2>/dev/null; then logger -t "$0" "Successfully configured $AWG_INTERFACE" break fi logger -t "$0" "Failed to configure $AWG_INTERFACE, retrying... ($COUNTER/$LIMIT)" sleep 1 COUNTER=`expr $COUNTER + 1` done if [ "$COUNTER" -gt "$LIMIT" ]; then logger -t "$0" "ERROR: Failed to configure $AWG_INTERFACE after $LIMIT attempts" fi } POSTCMD="post_cmd"

-

Гляньте, пожалуйста, в startup-config, сколько у вас уникальных двухбуквенных значений ft mdid <...> найдётся?

-

Получилось через CLI задать ft mdid на нужных точках, т.е. диапазоны одной сети объединились, но выглядит так что максимум может быть 3 уникальных значения ft mdid. Если больше - ошибка.

-

5.0.1. Можете проверить что в основном и доп сегменте у вас действительно в веб показывает что роуминг включен и на 2.4 и на 5ггц? Я могу в одном сегменте включить на оба диапазона, а в других только что-то одно сохраняется - или 2.4 или 5. Некоторые сети явно с отдельными именами, но у меня меш и задача иметь роуминг между точками.

-

Есть три сети, в каждой по два диапазона. Включить FT на всех сетях между всеми диапазонами нельзя что ли? Какие-то ограничения железа или что это? Отваливается с ошибкой, когда пытаюсь включить FT на более чем 3-х WiFi интерфейсах: mtkiappd too many AP interfaces (3)

-

В списке ретрансляторов надо нажать галочку на нужном и появится кнопка настроек. Это очень неочевидно, сам обнаружил буквально сегодня.