Mr.Weegley

Участники форума-

Постов

36 -

Зарегистрирован

-

Посещение

Оборудование

-

Устройства

keenetic giga kn-1011

Посетители профиля

Блок последних пользователей отключён и не показывается другим пользователям.

Достижения Mr.Weegley

Пользователь (2/6)

7

Репутация

-

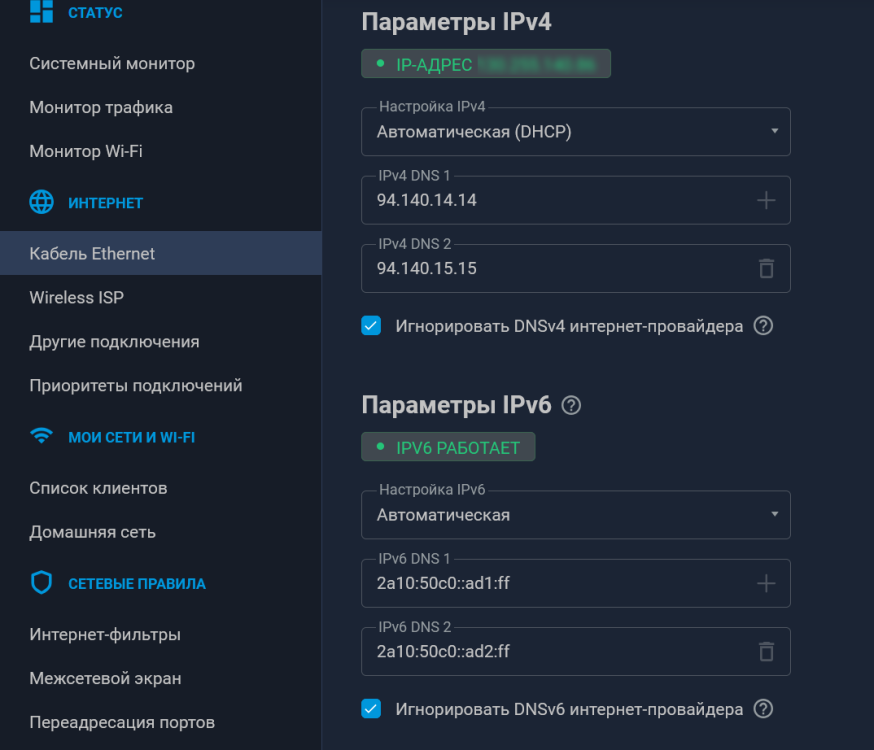

Просто прописал ДНС серверы Adguard вместо системных: Соответственно, в "Интернет-фильтры" ничего не включено. Как будто бы, робит уже довольно долго. И исчезла проблема с добавлением адресов в таблицы на странице "Маршруты ДНС"

-

Это бы в мануалах как то указать.. а ещё лучге на странице ДНС-маршрутизации. Ещё наблюдение: Ситуация та-же. Есть dualstack провайдер и wireguard vpn с поддержкой ipv6. При внесении адреса в таблицу днс маршрутизации, некоторые имена роутит только ipv4. ipv6 уходит через провайдера. например, whatsapp.com и nnmclub.to один отлично роутится через WG ipv6, второй через провайдерский. Думал - дело в адгуардовских днс серверах, вписанных вручную. Поставил гугловые - заработало, но при добавлении нового списка и новой записи - снова ipv4 роутит а ipv6 - нет. UPD: после принудительной смены системных резолверов всё начало роутиться верно.

-

дело не в самих ip. выглядит всё так, на данный момент, как будто включённый "Интернет-фильтры" мешает нормальной работе маршрутизации по днс.

-

Сейчас проверил. Конкретно с шазамом странно - Вот список: shazam.com www.shazam.com shazam.map.fastly.net san12.shazam.map.fastly.net 146.75.121.80 Пока не добавил прямой IP - не хотело роутить на www Далее - вообще странно. Отключил в фильтрах контента adguard DNS - всё заработало. Хватило одного shazam.com Такое чувство, что фильтры контента каким то образом мешают. Включил назад фильтр адгуард, очистил и внёс заново shazam.com - картина повторилась. не роутит пока не впишешь IP. Пока наблюдаю такое: Отключил адгуард - всё работает отлично. Включил - начинаются косяки. Последний тест по шагам: В списке только shazam.com Включённый Adguard - косяки. Отключаем Adguard - то же самое. Вносим изменение в список (просто добавляем перенос строки) - всё сразу работает, не смотря на CNAME. Вроде, так. Чуть позже попробую поэкспериментировать ещё. Да, и прошивка 5.0.0 уже

-

5.0b3 заметил вот что: Добавляем shazam.com получаем роутинг на него через нужный шлюз. а вот на www.shazam.com - уже нет. Подозреваю, что это из-за того что он резолвится в san12.shazam.map.fastly.net: C:\Users\Mr.Weegley>tracert -d shazam.com Трассировка маршрута к shazam.com [35.244.183.82] с максимальным числом прыжков 30: 1 <1 мс <1 мс <1 мс 192.168.0.1 2 70 ms 70 ms 70 ms 172.16.2.1 //шлюз в впн 3 70 ms 70 ms 70 ms 46.149.72.243 ^C C:\Users\Mr.Weegley>tracert -d www.shazam.com Трассировка маршрута к san12.shazam.map.fastly.net [146.75.121.80] с максимальным числом прыжков 30: 1 <1 мс <1 мс <1 мс 192.168.0.1 2 1 ms 1 ms <1 мс 10.10.1.4 //шлюз прова ^C C:\Users\Mr.Weegley> То есть, прежде чем вносить имена - нужно сначала выяснить их CNAME. Во всяком случае, у меня это работает именно так

-

Туннель рабочий. ИП обновляется. Я же написал, что у роутера ipv6 появляется. И клиентам отдаётся по SLAAC. Но не роутится. Роутер пингует по ipv6, клиенты не могут.

-

Не могу понять в чём дело. Некогда настроил туннель 6in4, и он благополучно работал. Но был отключён за ненадобностью. Сейчас же, включил, и доступ к Ipv6 есть только у роутера. Туннель рабочий. Роутер имеет ipv6 через него и работает. А вот клиентам адреса выделяются, но не маршрутизируются. В приоритетах туннель на первом месте, всё ок. ЧЯДНТ?

-

Коллеги, добрый день. Имею настроенный Wireguard сервер на кинетике с подсетью 172.16.3.0/24, Локалка 192.168.0.0/24 Хочется cделать LAN<->WG маршрутизируемым, а WG->интернет, соответственно NAT Сейчас получается только одно из двух: no ip nat Wireguard1 + маршрутизация = доступ LAN<->WG, но нет доступа из WG в интернет ip nat Wireguard1 всё работает, но из-за маскардинга подключения к сервису внутри LAN происходят от имени роутера. Можно ли как то сделать что бы клиенты WG ходили в интернет через NAT, а в локалку со своими ip? То есть: WG Clients ->NAT->Internet WG CLients ->FORWARD->LAN WG Clients ->FORWARD->WG Clients По возможности то же самое для LAN: LAN->NAT->Internet LAN->Forward->WG Clients PS Нашёл ответ на форуме: no ip nat Home no ip nat Wireguard1 no isolate-private (или добавить статические маршруты) ip static Wireguard1 ISP - Натим клиентов Wireguard в Интернет ip static Home ISP - Натим домашний сегмент в Интернет Единственная странность - no isolate-private и isolate-private как будто не дают никакой разницы. Пинги из WG в Home и назад бегают вне зависимости от настройки

-

ndp proxy на vps работает. Вернее, запущен. Я так и не понял правильно ли я там конфиг написал и, соответственно, работает ли оно вообще Конфиг ndppd на vps: А заодно, он запущен и на кинетике, со следующим конфигом: всё это каким то образом работает в одну сторону. Собственно, для моих нужд маршрутизация ipv6 в сторону клиентов и не нужна, а даже и вредна так как работает сидбокс, но в целом как то неполноценно получается... UPD Поотключал везде ndppd, заодно выяснив, что оно не правильно, по ходу настроено было. Поправил radvd, клиент получил свой ipv6 из подсети назначенной туннелю. Ходит в ipv6 по маршруту роутер->(wg)->vds->tunnelbroker->ipv6 Причем, ходит, даже имея только link-local и провайдерский адреса. И ipv6 адрес ipconfig.io показывает всегда верный. Мистика какая то. Клиент пингуется с роутера, но не пингуется извне. В моём конкретном случае меня это устраивает, поскольку работает раздача торрентом, но в целом - как то неполноценно.

-

Действительно, включил на роутере нативный IPV6 и клиенты получив его и fe80::/10 имеют доступ к ipv6 и через натив и через туннель. ipconfig.io показывает ipv6 клиента из подсети 2001 от HE, НО он не пингуется ни просто извне, ни даже с роутера. В общем, получается такой себе IP6NAT... Но хоть так...

-

Mr.Weegley подписался на IPv6 через туннель wireguard