Mr.Weegley

Участники форума-

Постов

36 -

Зарегистрирован

-

Посещение

Тип контента

Профили

Форумы

Галерея

Загрузки

Блоги

События

Весь контент Mr.Weegley

-

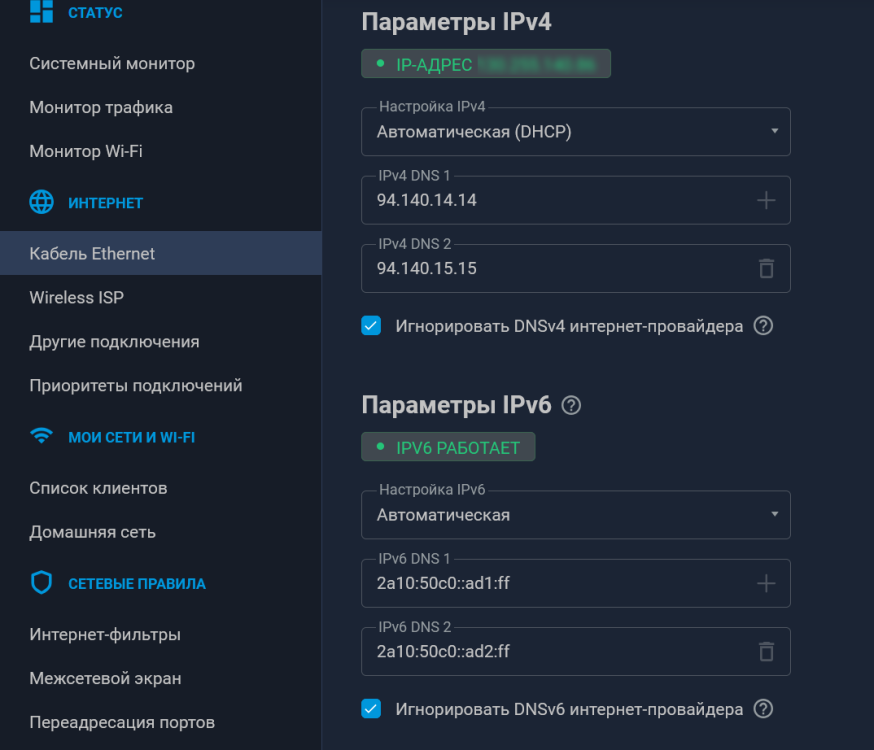

Просто прописал ДНС серверы Adguard вместо системных: Соответственно, в "Интернет-фильтры" ничего не включено. Как будто бы, робит уже довольно долго. И исчезла проблема с добавлением адресов в таблицы на странице "Маршруты ДНС"

-

Это бы в мануалах как то указать.. а ещё лучге на странице ДНС-маршрутизации. Ещё наблюдение: Ситуация та-же. Есть dualstack провайдер и wireguard vpn с поддержкой ipv6. При внесении адреса в таблицу днс маршрутизации, некоторые имена роутит только ipv4. ipv6 уходит через провайдера. например, whatsapp.com и nnmclub.to один отлично роутится через WG ipv6, второй через провайдерский. Думал - дело в адгуардовских днс серверах, вписанных вручную. Поставил гугловые - заработало, но при добавлении нового списка и новой записи - снова ipv4 роутит а ipv6 - нет. UPD: после принудительной смены системных резолверов всё начало роутиться верно.

-

дело не в самих ip. выглядит всё так, на данный момент, как будто включённый "Интернет-фильтры" мешает нормальной работе маршрутизации по днс.

-

Сейчас проверил. Конкретно с шазамом странно - Вот список: shazam.com www.shazam.com shazam.map.fastly.net san12.shazam.map.fastly.net 146.75.121.80 Пока не добавил прямой IP - не хотело роутить на www Далее - вообще странно. Отключил в фильтрах контента adguard DNS - всё заработало. Хватило одного shazam.com Такое чувство, что фильтры контента каким то образом мешают. Включил назад фильтр адгуард, очистил и внёс заново shazam.com - картина повторилась. не роутит пока не впишешь IP. Пока наблюдаю такое: Отключил адгуард - всё работает отлично. Включил - начинаются косяки. Последний тест по шагам: В списке только shazam.com Включённый Adguard - косяки. Отключаем Adguard - то же самое. Вносим изменение в список (просто добавляем перенос строки) - всё сразу работает, не смотря на CNAME. Вроде, так. Чуть позже попробую поэкспериментировать ещё. Да, и прошивка 5.0.0 уже

-

5.0b3 заметил вот что: Добавляем shazam.com получаем роутинг на него через нужный шлюз. а вот на www.shazam.com - уже нет. Подозреваю, что это из-за того что он резолвится в san12.shazam.map.fastly.net: C:\Users\Mr.Weegley>tracert -d shazam.com Трассировка маршрута к shazam.com [35.244.183.82] с максимальным числом прыжков 30: 1 <1 мс <1 мс <1 мс 192.168.0.1 2 70 ms 70 ms 70 ms 172.16.2.1 //шлюз в впн 3 70 ms 70 ms 70 ms 46.149.72.243 ^C C:\Users\Mr.Weegley>tracert -d www.shazam.com Трассировка маршрута к san12.shazam.map.fastly.net [146.75.121.80] с максимальным числом прыжков 30: 1 <1 мс <1 мс <1 мс 192.168.0.1 2 1 ms 1 ms <1 мс 10.10.1.4 //шлюз прова ^C C:\Users\Mr.Weegley> То есть, прежде чем вносить имена - нужно сначала выяснить их CNAME. Во всяком случае, у меня это работает именно так

-

Туннель рабочий. ИП обновляется. Я же написал, что у роутера ipv6 появляется. И клиентам отдаётся по SLAAC. Но не роутится. Роутер пингует по ipv6, клиенты не могут.

-

Не могу понять в чём дело. Некогда настроил туннель 6in4, и он благополучно работал. Но был отключён за ненадобностью. Сейчас же, включил, и доступ к Ipv6 есть только у роутера. Туннель рабочий. Роутер имеет ipv6 через него и работает. А вот клиентам адреса выделяются, но не маршрутизируются. В приоритетах туннель на первом месте, всё ок. ЧЯДНТ?

-

Коллеги, добрый день. Имею настроенный Wireguard сервер на кинетике с подсетью 172.16.3.0/24, Локалка 192.168.0.0/24 Хочется cделать LAN<->WG маршрутизируемым, а WG->интернет, соответственно NAT Сейчас получается только одно из двух: no ip nat Wireguard1 + маршрутизация = доступ LAN<->WG, но нет доступа из WG в интернет ip nat Wireguard1 всё работает, но из-за маскардинга подключения к сервису внутри LAN происходят от имени роутера. Можно ли как то сделать что бы клиенты WG ходили в интернет через NAT, а в локалку со своими ip? То есть: WG Clients ->NAT->Internet WG CLients ->FORWARD->LAN WG Clients ->FORWARD->WG Clients По возможности то же самое для LAN: LAN->NAT->Internet LAN->Forward->WG Clients PS Нашёл ответ на форуме: no ip nat Home no ip nat Wireguard1 no isolate-private (или добавить статические маршруты) ip static Wireguard1 ISP - Натим клиентов Wireguard в Интернет ip static Home ISP - Натим домашний сегмент в Интернет Единственная странность - no isolate-private и isolate-private как будто не дают никакой разницы. Пинги из WG в Home и назад бегают вне зависимости от настройки

-

ndp proxy на vps работает. Вернее, запущен. Я так и не понял правильно ли я там конфиг написал и, соответственно, работает ли оно вообще Конфиг ndppd на vps: А заодно, он запущен и на кинетике, со следующим конфигом: всё это каким то образом работает в одну сторону. Собственно, для моих нужд маршрутизация ipv6 в сторону клиентов и не нужна, а даже и вредна так как работает сидбокс, но в целом как то неполноценно получается... UPD Поотключал везде ndppd, заодно выяснив, что оно не правильно, по ходу настроено было. Поправил radvd, клиент получил свой ipv6 из подсети назначенной туннелю. Ходит в ipv6 по маршруту роутер->(wg)->vds->tunnelbroker->ipv6 Причем, ходит, даже имея только link-local и провайдерский адреса. И ipv6 адрес ipconfig.io показывает всегда верный. Мистика какая то. Клиент пингуется с роутера, но не пингуется извне. В моём конкретном случае меня это устраивает, поскольку работает раздача торрентом, но в целом - как то неполноценно.

-

Действительно, включил на роутере нативный IPV6 и клиенты получив его и fe80::/10 имеют доступ к ipv6 и через натив и через туннель. ipconfig.io показывает ipv6 клиента из подсети 2001 от HE, НО он не пингуется ни просто извне, ни даже с роутера. В общем, получается такой себе IP6NAT... Но хоть так...

-

Не совсем то, что я спрашивал. У меня на VPS /48 от HE. Клиенты WG настроенные вручную, включая и кинетик отлично работают. У всех /64 Но Кинетик отказывается делигировать свою сетку клиентам. Костыль AdvDefaultLifetime руками даёт эффект, но ровно до изменения статуса любого интерфейса. Дёрнул LAN кабель - всё в radvd.conf обновляется. То есть, либо городить какой-то hook с костылём, либо надеяться что разрабы добавят возможность ходить в ipv6 через Wireguard не только роутеру, но и его клиентам. UPD Думал, может префикс кинетику не нравится. Сделал ему на входе /52 - не помогло. До чего смог докопаться: ip6tables -A FORWARD -j ACCEPT - само собой. /var/run/radvd.conf меняем: В префиксе: AdvAutonomous off; на on - позволит дать клиентам адреса AdvPreferredLifetime 0; на значение в минутах (1440) - не совсем понял на кого влияет - на клиента или на роутер. Но без этой настройки на клиентах ipv6 хоть и назначен, но не работает. В общей части AdvDefaultLifetime 0; на значение в минутах (1440) - позволит назначить роутер маршрутизатором ipv6 по умолчанию для клиентов. /var/run/radvd.conf менять придётся после КАЖДОГО изменения статуса КАЖДОГО интерфейса. Во всяком случае локального - точно. Ну из killall -s HUP radvd Имеем нативный ipv6 на клиентах кинетика по цепочке: Клиент->Роутер->(wg)->VPS->(tun6in4)->HE->IPV6 internet. Ровно до изменения статуса какого-либо интерфейса. Осталось автоматизировать. По идее, если IPV6 получаем только статичные - можно просто сделать копию radvd.conf и подкладывать её перед перезапуском radvd. Но если есть ещё провайдерский ipv6 то нужно менять в файле как то А самое интересное что для 6in4 это всё отлично работает. Только вот мой пров включив нативный ipv6 похоже, перестал пропускать 6in4 трафик

-

Стоял Bird2 на Ultra (1011). Скрипт собирал маршруты с антизапрета, плюс свои. Всё писал в конфиг для птички. В тотале получался файл 2,86мб 80к+ (последний раз было 85535) маршрутов. Без проблем вообще. Когда добавил ему IPV6 (+118670 маршрутов) - закряхтел, но переварил. То есть, 204.2k маршрутов он способен держать и маршрутизировать. Отказался - был косяк в системе OPKG в целом. Сейчас снова настраиваю это дело.

- 3 ответа

-

- 1

-

-

После обновления появилась эта же проблема. Туннель 6in4 не создавал шлюз по умолчанию для ipv6. Поднял приоритет 6in4 выше основного подключения провайдера - отвалился ipv4 интернет... То есть, на данный момент лично у меня только один вариант - оставить приоритет подключения к прову выше туннеля и при старте роутера выполнять ipv6 route default <ipv6 gateway> Сделали бы хоть возможность этот маршрут сохранять при перезагрузке... Ну, или без NDM выполянть команды при запуске.

-

Попробуйте как выше указано: 1. protocol kernel kernel_routes { learn; scan time 60; ipv4 { import none; export all; }; kernel table 1000; # kernel routing table number #device routes yes; ##### } ^^^^^^^^^^^^^ Закоментить или раскомментить device routes (Уже не помню, почему у меня закомментировано) 2. protocol bgp antifilter { import filter { if martians() then reject; ifname = "wg0"; #accept; reject; }; export none; local as 64999; # local default as-number neighbor 45.154.73.71 as 65432; multihop; hold time 240; preference 250; } ^^^^^^^^^^^ добавить ifname = "wg0"; Не знаю, помогает ли чем-то multihop, но у меня работало без ошибок. А вообще, если работает, несмотря на эту запись в логе, то отправить лог в null и концы в воду...

-

Не помогло Наверное, переведу это дело тоже в Entware... Апстрим до VPS уже через Entware создаётся. Штатный клиент переставал работать через некоторое время. Помогала только смена ttl. Убрал штатный клиент и завёл его через Entware - всё работает, "ни единого разрыва" Теперь, видимо, пришла пора и сервер там же строить...

-

Добрый день! А вот эту жесть тоже только отрубив журналирование kernel можно победить? kernel: wireguard: Wireguard0: handshake for peer "PEER ID STOLEN BY UFO" (1) (172.16.1.2:0) did not complete after 5 seconds, retrying (try 2) У меня всего 2 клиента настроено, но среди спама что Wireguard генерит что то прочесть не реально

-

На трейсы бы глянуть с устройств и с самого кинетика. Только сейчас обратил внимание, что при установке подсети /24 при создании интерфейса через веб-морду, а так же командой ip - маска ставится /32. И только ifconfig смог установить её в /24. Но разницы не вижу. Работает и так и так при условии, что устанавливает BGP-сессию через туннель. Как только включил лог - снова спам о "странном" next-hop... Где то читал, что bird вообще плохо дружит с P-t-P интерфейсами. Да и по большому счёту он для другого пердназначен, вроде как. Сколько ни читал документации, форумов и мануалов по нему - складывается впечатление, что мы с его помощью из пушки по воробьям лупим